Die meisten Tech-Debatten drehen sich um Modelle, Parameter und Rechenleistung.

Aber der eigentliche Engpass liegt woanders. Er liegt bei uns. Genauer: bei unserer Fähigkeit, Entscheidungen zu treffen, die Maschinen noch nicht replizieren können – und diese Entscheidungen so zu strukturieren, dass Systeme daraus lernen.

Das klingt abstrakt. Ist es aber nicht. Es ist die Grundlage einer Industrie, die in den nächsten zehn Jahren auf einen dreistelligen Milliardenwert zusteuern wird. Nicht weil sie sexy ist, sondern weil sie unvermeidbar ist.

Was sich gerade verschiebt

Automatisierung war lange Zeit ein linearer Prozess. Systeme übernahmen Aufgaben, die klar abgrenzbar waren. Buchhaltung. Dateneingabe. Einfache Klassifikation. Der Mensch blieb für alles zuständig, was Kontext, Ambiguität oder Neuheit erforderte.

Doch seit einigen Jahren erleben wir eine neue Dynamik. Automatisierung entwickelt sich nicht mehr linear, sondern in Schleifen. Ein System übernimmt Aufgabe A. Menschen korrigieren Fehler, setzen neue Prioritäten, definieren Randfälle. Diese Korrekturen fließen zurück ins System. Das System verbessert sich. Neue Aufgaben werden automatisierbar. Der Zyklus beschleunigt sich.

Das Besondere: Dieser Kreislauf endet nicht. Er verdichtet sich. Und je dichter er wird, desto wichtiger wird die Qualität der menschlichen Eingabe. Nicht ihre Menge. Ihre Struktur.

Warum menschliche Urteile zum ökonomischen Primitivum werden

Drei Gründe.

Erstens: Modelle lernen aus Feedback. Aber nur, wenn dieses Feedback präzise, wiederholbar und systematisch erfasst wird. Ein Entwickler, der in einer Slack-Nachricht schreibt „das Ergebnis war komisch" erzeugt null Lerneffekt. Derselbe Entwickler, der in einer strukturierten Oberfläche angibt „Ausgabe ignoriert Constraint X, Priorität niedrig, Kontext: Legacy-System" erzeugt trainierbares Signal.

Zweitens: Kreativität und Automatisierung schließen sich nicht aus. Sie bedingen einander. Jede neue Automatisierungsschicht gibt kreative Kapazität frei. Diese Kapazität wird genutzt, um neue Systeme zu bauen, neue Randfälle zu definieren, neue Standards zu setzen. Dafür braucht es keine Masse an Menschen. Es braucht Menschen, die wissen, was sie bewerten – und Infrastruktur, die diese Bewertungen skalierbar macht.

Drittens: Die Fähigkeit, gute Urteile zu fällen, skaliert nicht automatisch. Sie ist eine Kompetenz. Und sie ist knapp. Nicht jeder kann beurteilen, ob ein rechtliches Dokument korrekt interpretiert wurde, ob eine Diagnose plausibel ist oder ob ein Code-Vorschlag sicherheitsrelevant ist. Diese Expertise wird nicht verschwinden. Sie wird zur Grundlage neuer Wertschöpfung.

Wie groß ist dieser Markt tatsächlich?

Nehmen wir eine konservative Annahme: Fünf Prozent der globalen Wissensarbeitszeit wird in den nächsten zehn Jahren in strukturierte, maschinell verwertbare Urteilsprozesse fließen. Nicht als separate Tätigkeit, sondern eingebettet in bestehende Workflows. Code-Reviews mit strukturiertem Feedback. Medizinische Diagnosen mit kategorisierten Unsicherheiten. Rechtstexte mit markierten Ambiguitäten.

Fünf Prozent klingen wenig. Aber bei einem globalen Wissensarbeitsmarkt von geschätzt 30 Billionen Dollar entspricht das 1,5 Billionen Dollar jährlich. Ein Teil davon fließt in Plattformen, Tooling, Infrastruktur. Ein anderer Teil in neue Rollen: Menschen, die nicht mehr produzieren, sondern bewerten, kuratieren, kalibrieren.

Das ist keine Science-Fiction. Es passiert bereits. Unternehmen wie Scale AI, Surge AI oder Labelbox bauen genau diese Infrastruktur. Sie heißen es nur noch „Annotation" – ein Begriff, der das Problem systematisch unterschätzt.

Warum wir aufhören sollten, von Annotation zu sprechen

Annotation klingt nach Nacharbeit. Nach etwas, das man outsourcen kann. Nach einem Kostenfaktor.

Aber was hier passiert, ist keine Nachbearbeitung. Es ist epistemische Infrastruktur. Es ist die Fähigkeit, Wissen so zu strukturieren, dass es für autonome Systeme nutzbar wird. Das ist keine Dienstleistung. Das ist eine Kernkompetenz.

Unternehmen, die das verstehen, werden ihre besten Leute nicht aus der Bewertungsschleife herausnehmen. Sie werden sie dort hineinziehen. Weil diese Schleife entscheidet, wie schnell ihre Systeme lernen. Und wie gut.

Was das konkret bedeutet

Wenn du heute Software baust, denkst du in Features, Pipelines, APIs. In fünf Jahren wirst du in Feedback-Loops denken. Wie schnell kann dein System aus menschlichem Urteil lernen? Wie strukturiert erfasst du Randfälle? Wie kalibrierst du neue Modelle auf Basis interner Expertise?

Die Unternehmen, die das besser machen als andere, werden schneller iterieren. Ihre Systeme werden präziser. Ihre Modelle werden verteidigbarer. Ihre Wettbewerbsvorteile werden schwerer kopierbar.

Das ist keine Frage der Technologie. Es ist eine Frage der Architektur. Und der Haltung.

Ein letzter Gedanke

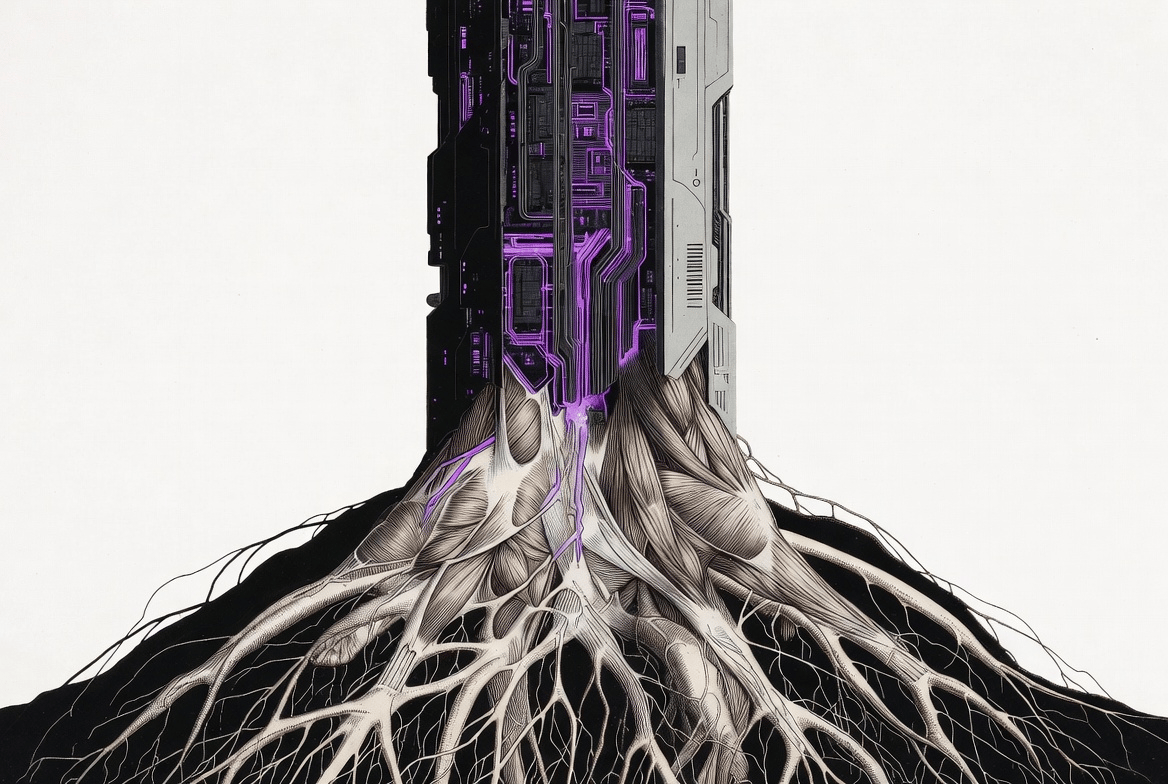

Die größte Verschiebung ist nicht, dass Maschinen menschliche Arbeit übernehmen. Die größte Verschiebung ist, dass menschliche Arbeit zur Grundlage maschinellen Lernens wird.

Wer das als Kostenfaktor sieht, wird verlieren. Wer es als Hebel sieht, wird definieren, wie die nächste Generation autonomer Systeme funktioniert.

Ich schreibe täglich über Denkmodelle und Hebel für Operatoren, die in dieser Umbruchphase nicht nur mithalten, sondern gestalten wollen. Wenn dich diese Perspektive weiterbringt, folge mir hier oder schreib mir eine Nachricht – ich teile gern, was funktioniert.